当下,AI 热潮汹涌澎湃,写周报、做设计、辅导作业…… 几乎只要你能想到的事,AI 都能手到擒来。此前,我们分享过许多在绿联 NAS 上部署 AI 大模型的教程,广受大家好评,不得不说,科技确实正在推动世界的进步。

然而,我们也听到了一些小伙伴的心声。有的小伙伴提到,部署教程篇幅较长,实在没有耐心看完;还有些不太懂技术的小伙伴,觉得教程里涉及的技术内容过于复杂,望而却步;更有小伙伴反馈,在运行 AI 时,速度不尽人意,极大地影响了使用体验。

为了积极响应用户需求,我们预计将推出 AI Plugins 应用。这款应用将针对 AI 在绿联 NAS 上的运行方式和体验进行全面优化与升级,致力于为大家带来简单高效的全新解决方案。

AI Plugins内置了Open WebUI、Ollama和IPEX-LLM三大核心组件,可在应用中心直接一键点击安装、可完全本地化操作,无需任何专业技术知识,让每一个用户都能轻松上手,无论是科技达人还是小白,都能快速开启AI之旅。

使用绿联AI Plugins和以往部署AI工具有什么不同?

1.调用GPU算力,推理速度显著提升,不再繁忙!

以往在传统NAS上运行Open WebUI容器,在没有显卡支持的情况下,主要依赖Intel的CPU进行计算任务。

虽然能够满足基本需求,但在处理复杂的AI模型和大量数据时,速度上难免会有些力不从心,出现延迟或卡顿的情况。

此次,AI Plugins应用创新性地引入了IPEX-LLM技术,让Intel的GPU也加入了计算行列。通过调用Intel GPU的硬件加速能力,在AI模型进行运算时,显著提升处理速度。

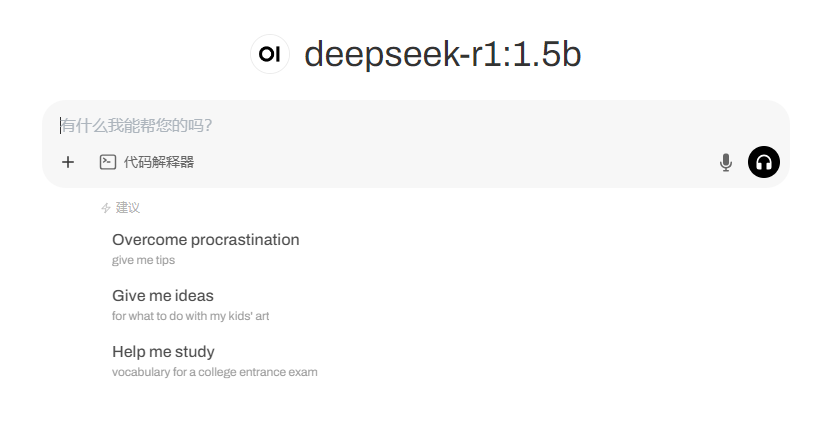

比如,同样是DeepSeek-R1:1.5b版本的情况下,之前运行Open WebUI容器在提问时,会出现等待时间过长的情况。

现在有了IPEX-LLM技术的加持,AI Plugins应用思考时间大大缩短,能够高效处理任务,响应及时,让数据处理再也不“服务器繁忙”,24小时随时待命响应你的需求。

2.内置模型,部署简单,新手友好!

上文也有提到,AI Plugins可在应用中心直接点击安装。(温馨提示,该套件较大,安装过程需要较长时间,请耐心等待直到安装完成。)

安装好后创建账号,登录进去就能使用内置的deepseek-r1:1.5b模型。纯本地化操作,隐私安全更有保障。

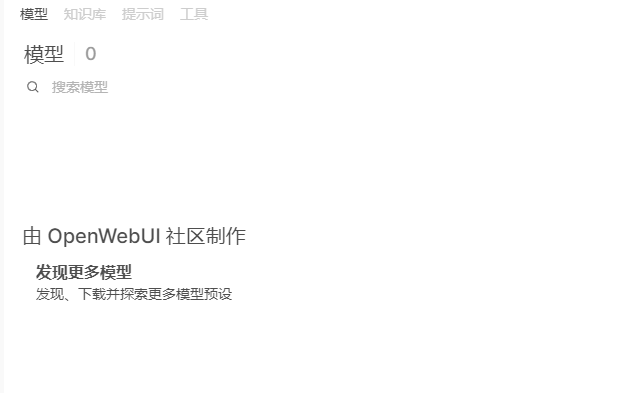

如果各位小伙伴不满足于使用DeepSeek,希望增加更多工具,还可以点击工作空间上的【发现更多模型】,直接跳转去下载其他AI模型。

而之前在Docker上部署,许多新手小伙伴第一步已经卡住,更别提后续步骤了。

如今内置AI模型应用上线,对新手小伙伴来说非常友好。

AI Plugins用起来难不难?我能怎么用?

当然不难!一个应用,全家通用!

在AI Plugins应用创建账号之后,全家人都可以登录使用。

对于宝妈宝爸们来说,孩子在学习过程中遇到数学难题时,AI可以进行详细讲解,还能出同类题目供孩子练习,成为孩子学习的好帮手。

职场人士可以利用它在短时间内生成周报、自动总结会议录音,大大提高工作效率,让老板对你的工作表现刮目相看。

还有语音功能,爷爷奶奶们也能轻松使用,通过AI查找菜谱、解答疑问等,享受科技养老带来的便利。

一个应用,一家共用,全家人共同的AI助手,新手轻松玩转高科技。

总结

绿联NAS AI Plugins应用是NAS与AI结合的产物,满足多样化需求、高效处理任务,它将成为你触手可及的日常助手,让每一个用户都能轻松驾驭。

最后,AI Plugins应用将在近期上线,请大家关注系统推送哦!